為保障AI安全防護,OpenAI公布有關ChatGPT的三大安全框架

(取自OpenAI X)

OpenAI認為,自己對於人工智慧災難性風險的科學研究還遠遠未達到需要的水準。

所以為了解決這一差距,OpenAI推出了「安全準備框架」,針對其追蹤、評估、預測和防範日益強大的模型帶來的災難性風險的流程,並總結OpenAI如何在實踐中最好地實現安全開發和部署的最新知識,建立防止不安全發展所需的流程。

透過評估追蹤災難性風險水準

(取自OpenAI官網)

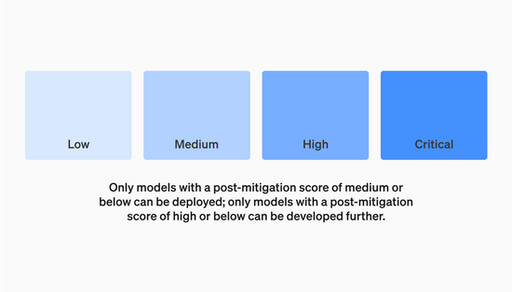

OpenAI使用AI模型的風險 「記分卡」 來衡量和追蹤潛在風險的各種指標,並在記分卡中表明當下緩解前後的風險等級。

此外,還能預測風險的未來發展,不斷完善、更新安全框架。

建立安全基線

OpenAI設定了嚴格的安全基線,只有在減輕後評分為「中等」或以下的模型才能部署,並且只有安全評分為「高」的模型才能進一步開發、應用。

此外,對於評分卡中具有「高」或「關鍵」風險的模型,OpenAI還將確保其相對應的安全措施,以防止模型被洩漏、竊取。

建立安全諮詢小組

OpenAI將建立一個跨職能諮詢機構「安全諮詢小組」以及「準備團隊」,除了需進行風險評估與研究監督工作、維護應急情況處理的快速流程之外,還要彙整公司內部的專業知識,為OpenAI領導層和董事會做出最佳緩解措施及安全決策做好準備,而準備團隊將定期向安全諮詢小組提供報告。

OpenAI強調將持續致力於進行確保AGI安全所需的研究,所以「安全準備框架」只是其中的一部分,另外還針對減少偏見、幻覺和誤用方面的投資,以及促進對人工智慧的民主投入等進行多方研究與推進。

- 記者:Knowing新聞

- 更多科技新聞 »